Bei assono nutzen wir große Sprachmodelle (LLMs) in Chatbot-Projekten für unterschiedliche Funktionen. Neben den redaktionellen Hilfen im Dashboard kann der assono KI-Chatbot auch in Gesprächen auf LLMs zurückgreifen. Die Fähigkeit, Texte zu generieren, wird genutzt, um dynamische Inhalte wie Informationen aus angebundenen Datenbanken oder Suchergebnisse automatisch anzupassen. Dadurch können Texte sprachlich an die gestellte Frage angepasst und spezifische Informationen extrahiert werden.

Spezifische Informationen extrahieren

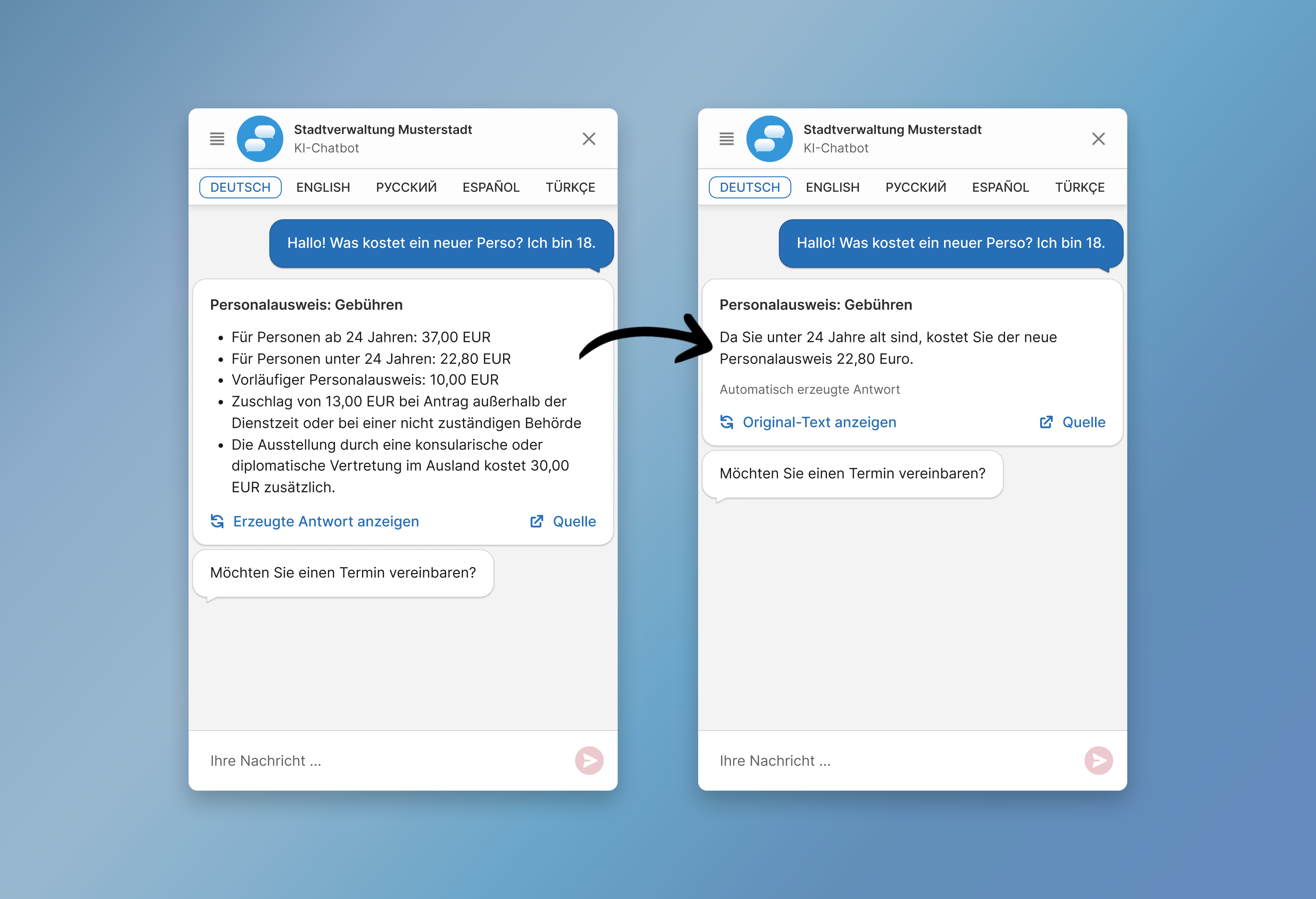

Im ersten Szenario fragt eine Person den KI-Chatbot nach spezifischen Informationen zu Preisen für einen Personalausweis. Der entsprechende Datenbankeintrag enthält zwar alle erforderlichen Details zur Beantwortung der Frage, aber auch zusätzliche, nicht relevante Informationen. In diesem Fall werden sowohl die Nutzerfrage als auch der Inhalt des Datenbankeintrags an das LLM übergeben und in einem Prompt verarbeitet. Das LLM ist dann in der Lage, eine Antwort zu generieren, die präzise auf die Nutzerfrage zugeschnitten ist.

Texte sprachlich anpassen

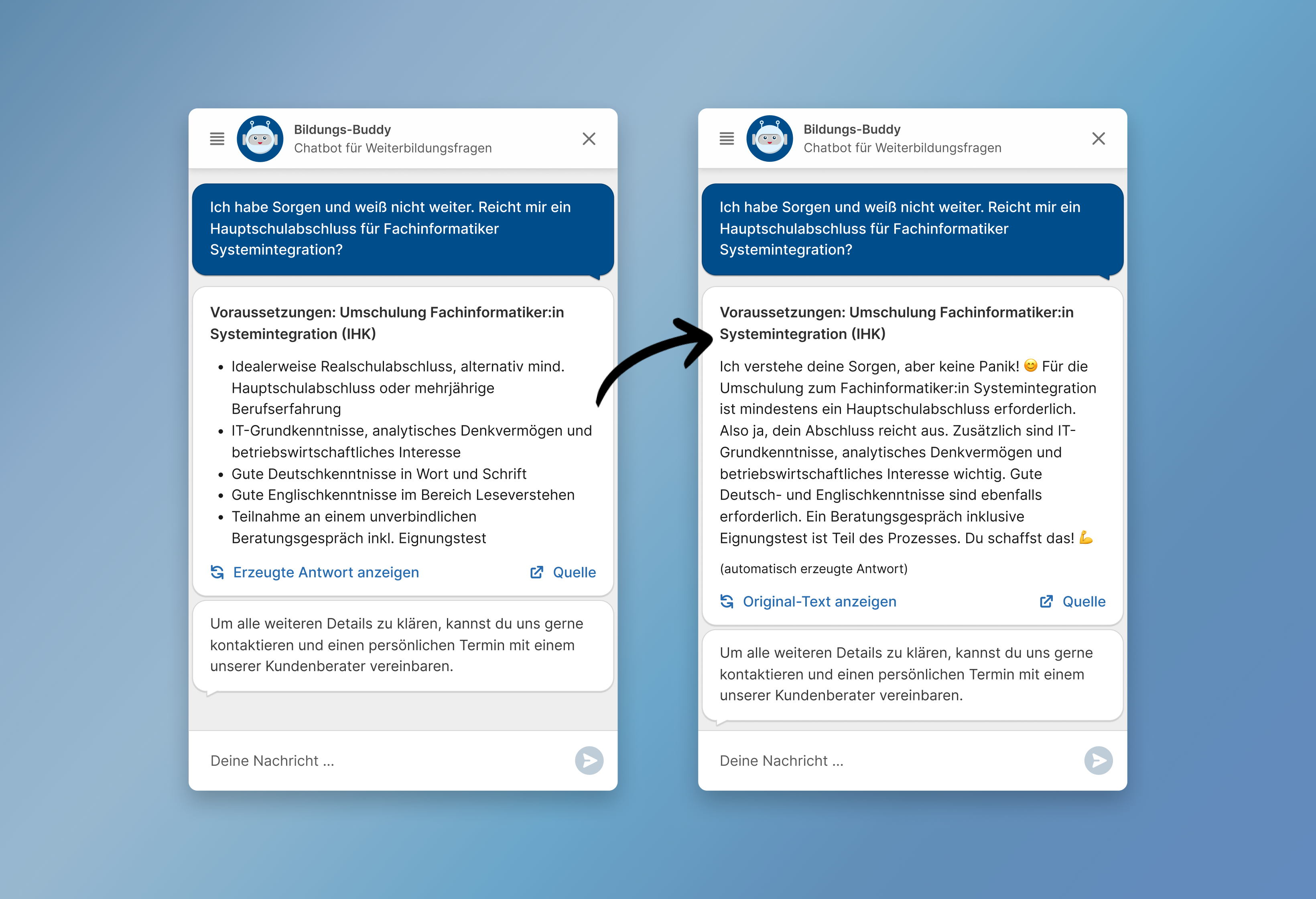

In einem anderen Szenario fragt eine Person nach den Voraussetzungen für eine Umschulung bei einem Weiterbildungsanbieter. Der Datenbankeintrag enthält viele relevante Informationen, diese werden jedoch nur in Form einer Auflistung präsentiert. Hier kommt ein weiterer Vorteil der Verwendung von LLMs zum Tragen: die sprachliche Anpassung. Sowohl die Nutzerfrage als auch der Inhalt des Datenbankeintrags werden an das LLM übergeben und in einem Prompt verarbeitet. Jetzt kann das Modell eine Antwort generieren, die nicht nur inhaltlich passend, sondern auch sprachlich an den Stil der Chatbot-Persona angepasst ist. Dies trägt dazu bei, den Dialog natürlicher zu gestalten und somit das Nutzererlebnis zu verbessern.

Kontrolle, Transparenz und Nachvollziehbarkeit

Auch eineinhalb Jahre nach der Einführung von ChatGPT sind Halluzinationen, also die Ausgabe von Falschinformationen, die sich das LLM ausgedacht hat, eine große Herausforderung. Wir wählen daher einen Ansatz ähnlich zu Retrieval Augmented Generation (RAG), bei welchem die relevanten Daten zuerst in verlässlichen Quellen gesucht und diese anschließend von einem LLM zusammengefasst werden. So können wir die Vorteile eines LLMs nutzen, haben aber trotzdem ein hohes Maß an Kontrolle, Transparenz und Nachvollziehbarkeit.

- Kontrolle: Durch die Anbindung an Datenbanken und eine KI-Suche auf ausgewählten Webseiten behalten Sie die Kontrolle über die Inhalte, die dem LLM für die Generierung von Antworten zur Verfügung stehen. Auf diese Weise stellen Sie sicher, dass das LLM nur auf relevante und vertrauenswürdige Informationen zugreift.

- Transparenz: Bei zusammengefassten Antworten erscheint im Chatfenster immer der Hinweis, dass es sich bei dem Text um eine automatisch generierte Antwort handelt. Hierfür wird der Hinweis „automatisch erzeugte Antwort“ angezeigt.

- Nachvollziehbarkeit: Benutzer haben immer die Möglichkeit, sich den Original-Text direkt im Chatfenster anzeigen zu lassen und einfach zwischen den beiden Ansichten zu wechseln. Zudem wird ein Link zur Quelle bereitgestellt, damit Nutzer die Möglichkeit haben, die Quell-Website zu besuchen.

Klingt interessant?

Sie würden gerne unverbindlich mehr darüber erfahren, inwiefern ein KI-Chatbot in Ihr Unternehmen oder Ihre Organisation unterstützen kann? Gerne beraten wir Sie dazu in einem kostenlosen Erstgespräch. Vereinbaren Sie doch einfach einen Termin über unsere Webseite. Telefonisch erreichen Sie uns unter +49 4307 900 407.

Oder nutzen Sie die Chance und seien Sie beim nächsten Demo-Termin dabei! In regelmäßigen Abständen führen wir Online-Präsentationen durch, bei denen sich unsere Chatbot-Experten und ca. 5–15 externe Teilnehmer aus derselben Branche über konkrete Anwendungsfälle austauschen. Wir sprechen über die Vorteile eines KI-Chatbots speziell für Ihre Branche, teilen Erfahrungswerte aus der Praxis und zeigen Ihnen eine Live-Demo. Nächste Demo-Termine finden Sie hier. Wir freuen uns auf Sie!